本文共 1919 字,大约阅读时间需要 6 分钟。

我们已经训练机器学习系统来识别物体,进行导航,或识别面部表情,但尽管可能很难,机器学习甚至没有达到可以模拟的复杂程度,例如,模拟一只狗。那么,这个项目的目的就是做到这一点——当然是用一种非常有限的方式。通过观察一只非常乖巧的狗的行为,这个AI学会了如何像狗一样行动的基础知识。

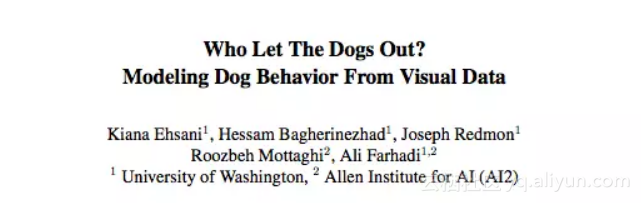

这是华盛顿大学和艾伦人工智能研究所合作的研究,论文发表在今年6月举办的CVPR。

摘要

我们研究了如何直接建模一个视觉智能体(visually intelligent agent)。计算机视觉通常专注于解决与视觉智能相关的各种子任务。但我们偏离了这种标准的计算机视觉方法;相反,我们试图直接建模一个视觉智能的agent。我们的模型将视觉信息作为输入,并直接预测agent的行为。为此,我们引入了DECADE数据集,这是一个从狗的视角搜集的狗的行为数据集。利用这些数据,我们可以模拟狗的行为和动作规划方式。在多种度量方法下,对于给定的视觉输入,我们成功地对agent进行了建模。此外,与图像分类任务训练的表示相比,我们的模型学习到的表示能编码不同的信息,也可以推广到其他领域。特别是,通过将这种狗的建模任务作为表示学习,我们在可行走表面预测(walkable surface estimation)和场景分类任务中得到了非常好的结果。

理解视觉数据:模仿狗,学习狗

为什么做这个研究?虽然已经有很多工作在研究模拟感知的子任务,例如识别一个物体并将其捡拾起来,但是“理解视觉数据,达到可以让agent在视觉世界中采取行动并执行任务的程度”,这样的研究很少。换句话说,不是模拟眼睛的行为,而是模拟控制眼睛的主体。

那么为什么选择狗?因为狗是非常复杂的智能体,研究者说:“它们的目标和动机往往是没法预知的。”换句话说,狗狗很聪明,但我们不知道它们在想什么。

作为对这一研究领域的初步尝试,该团队希望通过密切监视狗狗的行为,并将狗狗的运动和行动与所它看到的环境相对应,来观察是否能够建立一个能够准确预测这些行动的系统。

将一套传感器装在一直爱斯基摩犬身上,收集数据

为了达到这一目的,研究者把一套基础传感器装在一只名叫Kelp M. Redmon的爱斯基摩犬身上。他们在Kelp的头部装上一个GoPro相机,6个惯性测量单元(分别在腿、尾巴和身体上)用以判断物体的位置,一个麦克风以及一个把这些数据绑在一起的Arduino开发板。

他们花了许多小时记录狗狗的活动——在不同的环境中行走,取东西,在狗公园玩耍,吃东西——并把狗的动作与它看到的环境同步。结果是形成了一个在狗的环境中以狗自身为视角的行为数据集(Dataset of Ego-Centric Actions in a Dog Environment),简称为DECADE数据集。研究者用这个数据集来训练一个新的AI智能体。

对这个agent,给定某种感官输入——例如一个房间或街道的景象,或一个飞过的球——以预测狗在这种情况下会做什么。当然,不用说特别细节,哪怕只是弄清楚它的身体如何移动,移向哪里,已经是一项相当重要的任务。

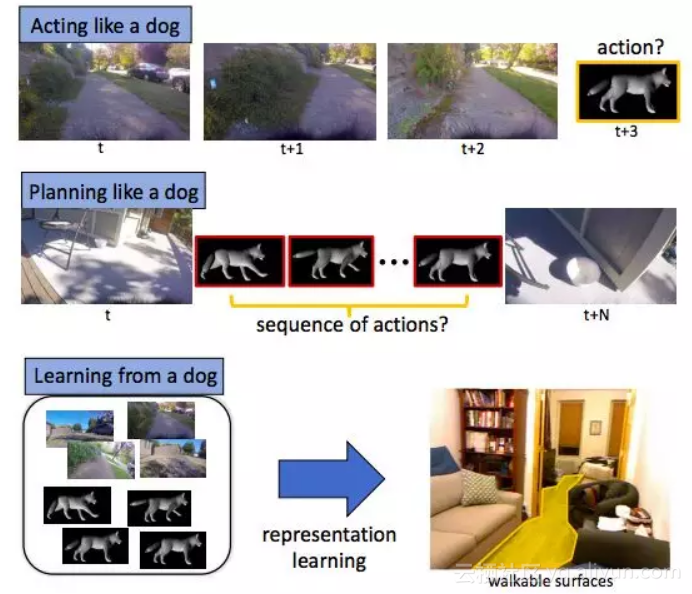

华盛顿大学的Hessam Bagherinezhad是研究人员之一,他解释道:“它学会了如何移动关节以走路,学会了再走路或跑步是如何避开障碍物。”“它学会了追着松鼠跑,跟随者主人走,追逐飞起来的狗玩具(玩飞盘游戏时)。这些都是计算机视觉和机器人技术的一些基本AI任务(例如运动规划、可步行的表面、物体检测、物体跟踪、人物识别),我们一直试图通过为每个任务收集单独的数据来解决。”

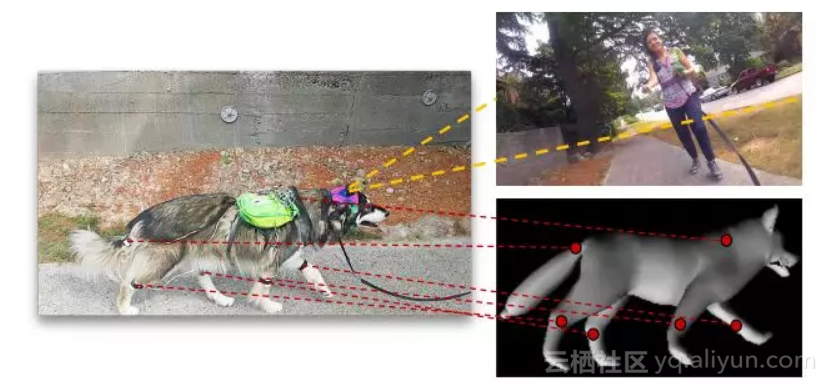

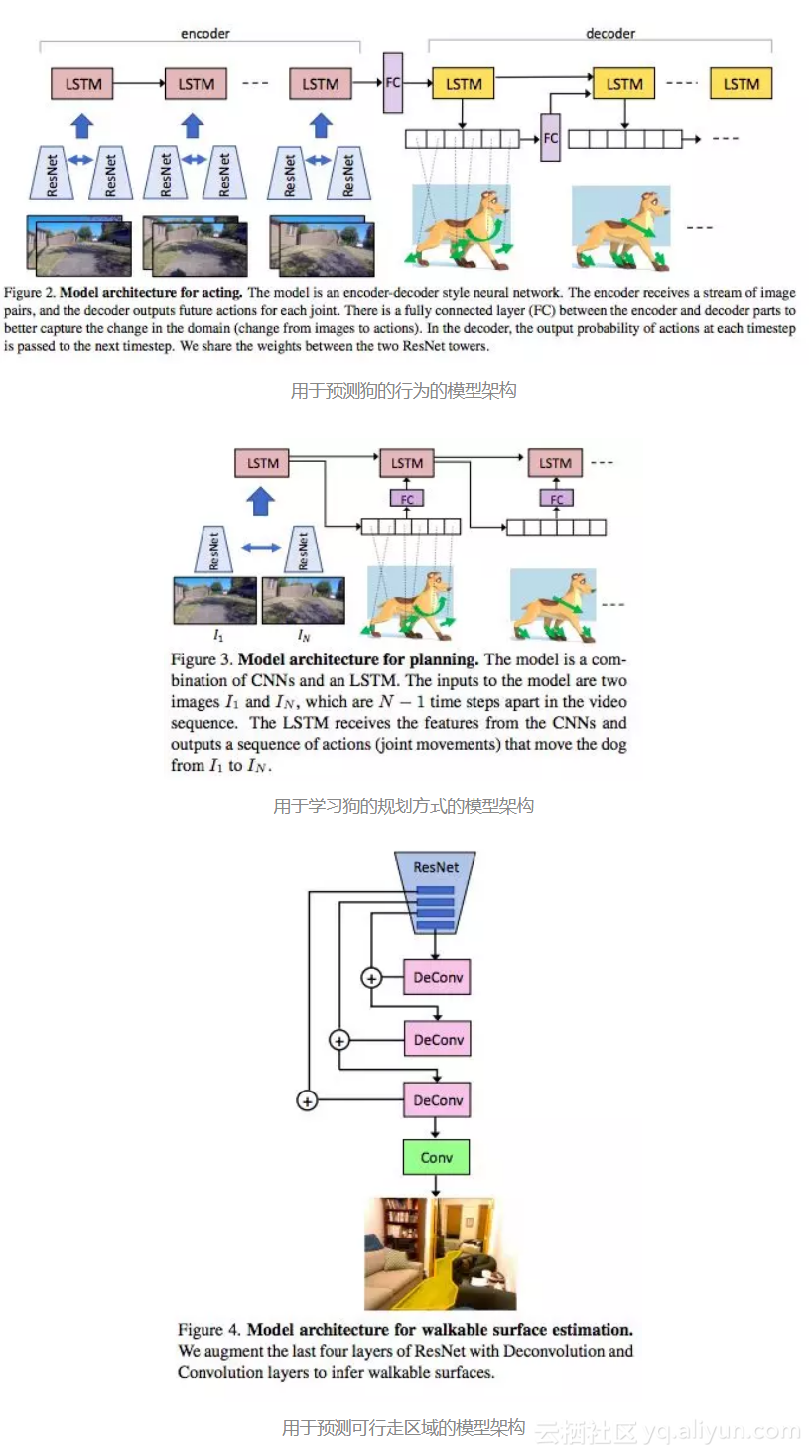

研究提出三个问题:(1) 模仿狗的行为:根据狗之前的行为图像,预测狗接下来的行为;(2) 像狗一样规划行动;(3)从狗的行为学习:例如,预测一个可供行走的区域。

这些任务可以产生一些相当复杂的数据:例如,狗模型必须知道,就像真的狗狗一样,当它需要从一个地点移动到另一地点的时候,它可以在哪些地方行走。它不能在树上或汽车上行走,也不能在沙发上行走(取决于房子)。因此,这个模型也学会了这一点,它可以作为一个计算机视觉模型单独部署,用以找出一个宠物(或一个有足机器人)在一张给定图像中可以到达的位置。

研究人员说,这只是一个初步的实验,虽然取得了成功,但结果有限。后续研究可能会考虑引入更多的感官(例如嗅觉),或者看看一只狗(或许多狗)的模型可以如何推广到其他狗身上。他们的结论是:“我们希望这项工作为我们更好地理解视觉智能和其他生活在我们世界里的智能生物铺平道路。”

原文发布时间为:2018-04-13

本文作者:肖琴

本文来自云栖社区合作伙伴新智元,了解相关信息可以关注“AI_era”。

原文链接:

转载地址:http://lnvpa.baihongyu.com/